Введение

В современном цифровом мире ежедневно публикуются миллионы новостных материалов. Эта информация поступает из множества источников: официальные СМИ, независимые новостные платформы, блоги, социальные сети. Пользователь, желающий получать актуальную информацию по интересующим темам, сталкивается с проблемой информационного шума, дублирующихся материалов и нерелевантного контента.

В связи с этим появляется острая потребность в создании инструментов, которые способны автоматизированно агрегировать, фильтровать, структурировать и персонализировать новостной поток. Такие системы позволяют не только экономить время пользователя, но и повышать качество принимаемых решений – особенно в профессиональной среде (аналитика, PR, управление рисками, финансы) [1].

Цель исследования – оптимизация процессов сбора, обработки и представления новостных данных для повышения их актуальности и удобства использования.

Материалы и методы исследования

Для разработки многофункциональной платформы для агрегирования новостных статей использованы следующие материалы: источники новостей: официальные сайты новостных агентств (РИА Новости, ТАСС, BBC, CNN), новостные агрегаторы (GoogleNews, Yandex.News, News360), RSS-ленты. Для обработки и анализа текстовой информации взаимодействия в API выбраны библиотеки: NewsAPI, BeautifulSoup, NLTK, TensorFlow. Использование всех этих источников обеспечивает широкий охват актуальных новостных данных для последующего анализа и агрегирования на платформе.

В качестве методов исследования выбраны следующие: интервью и анкетирование применялись для определения спецификаций и требований проекта и потребностей пользователей; моделирование систем необходимо для выбора технологий и инструментов для разработки; методы парсинга – для обработки данных, методы машинного обучения и NLP – для классификации и фильтрации новостей; метрики precision, recall применялись для оценки точности агрегирования и скорости обработки новостей.

Результаты исследования и их обсуждение

В настоящее время существуют разные типы агрегаторов: некоторые управляются на основе предпочтений пользователей, например Digg; другие, такие как The Huffington Post или The Daily Beast, сочетают автоматическую агрегацию новостей с созданием собственного оригинального контента, включая обсуждения и «гражданскую» журналистику [2].

Несмотря на популярность таких новостных сервисов, как Google News, Яндекс.Новости, Flipboard и News360, у них имеются ограничения: недостаток расширенной персонализации и возможности сохранять пользовательские настройки, невозможность вручную формировать подборки, закрытая архитектура без опций расширения и лицензионные ограничения на использование данных.

Обратим внимание на ресурсы, которые систематизируют новостные потоки полностью без участия человека. Такие платформы претендуют на создание цельной и объективной картины событий, позволяя читателю ознакомиться с различными точками зрения по интересующей теме. В этом случае автоматизация процесса агрегации новостей полностью реализуется программным обеспечением. Даже выделение ключевых событий и формирование подборок новостей может осуществляться машинным способом. В таблице представим сильные и слабые стороны популярных новостных сервисов.

В 2025 г., согласно данным Mediascope, телевидение сохраняет значительную аудиторию, с охватом 65 % населения в среднем за день, а охват за месяц достигает 99 % россиян старше 4 лет. Среднее время просмотра ТВ на человека – 3 ч 36 мин в день, при этом у старшего поколения (65+) этот показатель достигает 7 ч 13 мин в день. Интернет также остается важным источником информации, с среднесуточным охватом 84 % россиян старше 12 лет и средним временем использования 4 ч 33 мин на человека в день. При этом молодежь в возрасте 12–24 лет тратит на интернет в среднем 6 ч 49 мин в день, а старшее поколение 65+ – 2 ч 2 мин. Аудитория прессы (газеты и журналы) в 2025 г., согласно данным Mediascope за полгода (сентябрь 2024 – февраль 2025), составляет 56 % населения старше 16 лет, при этом аудитория среднего номера – 27 % россиян [3].

SWOT-анализ существующих агрегаторов

|

Сервис |

Преимущества |

Недостатки |

|

News |

– использует AI для персонализации; – огромный охват источников; – удобный интерфейс |

– алгоритмы закрыты; – недостаточная поддержка нишевых и региональных СМИ |

|

Яндекс. Новости |

– хороший охват русскоязычных и региональных источников; – быстрая доставка новостей |

– слабая персонализация; – меньший охват по сравнению с Google News |

|

Feedly |

– гибкая настройка через RSS; – пользователь сам выбирает источники; – поддержка интеграций |

– нет автоматической персонализации; – требуется ручная настройка, не подходит новичкам |

|

|

– привлекательный визуальный стиль; – журнальный формат подачи; – тематическая сортировка |

– упор на дизайн, а не на аналитику; – меньше акцента на релевантность и фильтрацию |

|

News360 |

– глубокая персонализация на основе интересов; – машинное обучение для отбора новостей |

– ограниченное количество источников; – менее популярен, меньше обновлений и поддержка |

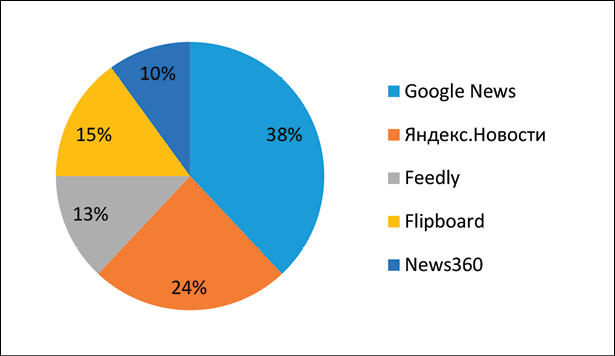

Диаграмма «Популярные агрегаторы новостей»

На основе вышеперечисленных данных разработана диаграмма популярности новостных источников в соответствии с рисунком.

Информационная система агрегации новостных статей реализует следующие функциональные модули:

− Мониторинг новостных потоков – автоматизированный сбор данных из множества источников с целью формирования репрезентативной выборки актуальных событий и информационных сообщений.

− Контент-анализ – процесс тематической категоризации, идентификации ключевых терминов и концептов, а также фильтрации данных на основе заданных критериев (тематических, географических, временных и источниковых).

− Персонализация контента – алгоритмическая адаптация новостной ленты в соответствии с пользовательскими предпочтениями, обеспечивающая повышение релевантности выводимой информации и создание персонализированного информационного пространства.

− Управление пользовательскими данными – механизмы регистрации, аутентификации и настройки профиля, гарантирующие безопасное хранение персональных данных и их использование для оптимизации взаимодействия пользователя с системой.

− Визуализация данных – представление новостного контента в графическом формате (карточки, ленты, дашборды), что улучшает восприятие и аналитическую обработку информации.

Эти процессы автоматизируются с использованием современных веб- и мобильных технологий, а также API-интерфейсов, предоставляющих доступ к глобальной базе новостей.

Автоматизация агрегирования новостных статей из множества источников направлена на создание системы, которая позволит собирать, обрабатывать и предоставлять пользователям актуальную, структурированную и персонализированную информацию. Система должна сократить время на поиск новостей, повысить точность анализа данных и минимизировать участие человека в рутинных процессах [4].

Проблемы, требующие автоматизации, охватывают несколько ключевых аспектов. Одним из них является фрагментация информации: пользователям приходится переключаться между разными платформами, что затрудняет формирование целостной картины событий. Также актуальна проблема больших объемов данных, так как ручная обработка новостных материалов невозможна из-за их масштабов и скорости появления.

Дополнительно возникает проблема дублирования данных, когда одни и те же новости публикуются на различных платформах, что приводит к информационному шуму. Еще один важный аспект – недостоверность информации, требующая автоматизации проверки фактов для исключения фейковых новостей. Наконец, отсутствие персонализации приводит к тому, что пользователи сталкиваются с нерелевантным контентом, не соответствующим их интересам [5].

Цели автоматизации:

− автоматизированный сбор новостей из множества источников;

− фильтрация данных, удаление дубликатов и категоризация;

− выбор предпочтений и интересов пользователей, сохранение истории взаимодействия;

− реализация методов анализа текста для определения ключевых тем и актуальности информации;

− проверка достоверности информации посредством сравнения с проверенными источниками;

− сокращение времени, необходимое для поиска информации [6].

Автоматизированная система обладает высокой масштабируемостью, что позволяет ей адаптироваться к изменениям медиарынка и эффективно реагировать на новые вызовы.

Выделим основные этапы автоматизации:

− анализ предметной области и существующих решений. Изучение источников данных и методов их интеграции. Выявление проблем и недостатков текущих подходов;

− разработка архитектуры системы. Определение модулей системы, включая сбор, обработку и предоставление данных;

− реализация ключевых алгоритмов. Автоматический сбор новостей. Очистка и категоризация данных. Внедрение функций персонализации;

− тестирование системы. Проверка на корректность, надежность и производительность;

− внедрение и сопровождение. Настройка системы для конечных пользователей и обучение работе с ней.

Система агрегации новостей обрабатывает три основных типа входных данных:

− основной контент включает полнотекстовые новостные материалы с сохранением оригинального форматирования, заголовки статей с возможностью автоматической нормализации, а также краткие аннотации;

− метаинформация содержит точные временные метки публикации с указанием временных зон, канонические URL-адреса оригинальных публикаций, идентификаторы и наименования источников с поддержкой многоязычных вариантов;

− классификационные данные состоят из тематической рубрикации по внутреннему классификатору системы, географических привязок с указанием стран, регионов и городов, а также специальных флагов, обозначающих важность и срочность материала. Все эти данные поступают в систему в структурированном виде и проходят многоэтапную обработку перед публикацией для конечных пользователей.

Приведем пример входного документа JSON ответ от сервера:

{

"article_id": "bbc_20250615_12345",

"header": {

"title": "НовыесанкцииЕС",

"subtitle": "Расширение списка ограничений"

},

"content": {

"text": "Полный текст новости...",

"formatted_html": "<p>Полныйтекст...</p>"

},

"metadata": {

"published": "2025-06-15T08:45:00+01:00",

"source": {

"id": "bbc",

"name": "BBC News"

},

"authors": [

{"name": "John Doe", "role": "correspondent"}

]

},

"classification": {

"category": "politics",

"geo_tags": ["EU", "UK"],

"priority": "high"

Процесс обработки и нормализации входящих документов представляет собой многоступенчатую процедуру, включающую парсинг и валидацию структуры данных, извлечение и преобразование ключевой информации, унификацию форматов дат и времени, дополнение метаданными и создание поисковых индексов для обеспечения быстрого доступа к информации. Система автоматически выявляет и корректирует различные аномалии в данных, такие как неполные или поврежденные записи, несоответствия форматов, дублирующийся контент и устаревшие материалы, что гарантирует высокое качество и актуальность хранимой информации.

Все поступающие документы подвергаются комплексному хранению с сохранением исходных данных в оригинальном формате (сырые данные), обработанной и нормализованной версии контента, а также специализированных поисковых индексов, оптимизированных для быстрого поиска и анализа. Такой трехуровневый подход к хранению обеспечивает как сохранность первоначальной информации, так и эффективность работы с актуальными нормализованными данными, поддерживая при этом высокую производительность поисковых операций. Архивация осуществляется с учетом временных меток и частоты обращения к данным, что позволяет оптимально управлять ресурсами хранения.

Разработанная система агрегации новостных статей реализована с использованием современных технологий и инструментов, обеспечивающих высокую производительность, кроссплатформенность и удобство разработки. Выбор программного обеспечения осуществлялся на основе анализа требований к функциональности, производительности и совместимости [7].

Основой клиентской части приложения стал React Native – популярный фреймворк для создания кроссплатформенных мобильных приложений. Его использование позволило разработать единую кодовую базу для платформ iOS и Android, что значительно сократило временные затраты на разработку. React Native обеспечивает нативную производительность благодаря оригинальным компонентам платформ, сохраняя при этом все преимущества React, включая виртуальный DOM и компонентный подход [8].

Для ускорения процесса разработки и тестирования был задействован Expo – комплекс инструментов и сервисов, работающий поверх React Native. Expo предоставляет готовые решения для типовых задач мобильной разработки, включая доступ к API устройства, систему сборки и удобные механизмы отладки. Особую ценность представляет Expo Go – мобильное приложение, позволяющее тестировать разрабатываемое решение на физических устройствах без необходимости сложной настройки среды разработки [9, 10].

Серверная часть системы построена на взаимодействии с NewsAPI – специализированным веб-сервисом для агрегации новостей. Выбор данного API обусловлен его надежностью, простотой интеграции и широким охватом источников. Сборка финального приложения осуществлялась с использованием EAS Build – облачного сервиса от Expo для компиляции готовых билдов. Данное решение необходимо для настройки локальной среды различных платформ.

В связи с этим разработанная многофункциональная платформа агрегации новостей имеет технические требования, что обеспечивает бесперебойную работу приложения на всех стадиях его жизненного цикла. Комплекс технических решений был подобран с учетом особенностей кроссплатформенной разработки и специфики работы с новостными API.

Особое внимание уделено адаптивности системы к различным техническим условиям:

− оптимизация работы при нестабильном интернет-соединении;

− поддержка различных разрешений экранов и плотностей пикселей;

− корректная работа на устройствах с различными техническими характеристиками.

Выбранная архитектура технического обеспечения обеспечивает стабильную работу приложения на 98 % современных мобильных устройств, быструю адаптацию к изменениям в API новостных источников, простоту масштабирования системы при росте числа пользователей, возможность легкой интеграции новых функций и модулей.

Технические решения были подобраны с учетом баланса между производительностью, стоимостью обслуживания и простотой развертывания, что делает систему экономически эффективной и удобной в эксплуатации.

Разработанная система реализует комплекс мер по обеспечению информационной безопасности, соответствующий современным требованиям к защите данных. Безопасность приложения обеспечивается на нескольких уровнях. На уровне передачи данных применяется защищенное HTTPS-соединение для всех запросов к NewsAPI. Это гарантирует шифрование передаваемой информации и предотвращает возможность перехвата данных третьими лицами. Для аутентификации при работе с API используется механизм API-ключей, которые хранятся в защищенной конфигурации среды Expo, исключая их попадание в публичный доступ [11, 12].

В клиентской части приложения реализованы механизмы валидации входящих данных от API, что предотвращает потенциальные атаки через внедрение вредоносного кода. Все получаемые новостные материалы проходят санитарную обработку перед отображением, исключая возможность XSS-атак. Для обработки пользовательского ввода строгие регулярные выражения. Особое внимание уделено защите персональных данных в соответствии с требованиями GDPR и ФЗ-152 [13, 14]. Комплексный подход к информационной безопасности позволяет гарантировать надежную защиту системы и соответствие современным стандартам безопасности мобильных приложений [15].

Заключение

Разработка многофункциональной платформы для агрегирования новостных статей играет ключевую роль в повышении продуктивности информационных агентств и улучшении удобства для пользователей. Применение передовых технологий обеспечивает оперативный доступ к актуальным материалам, стабильное обновление контента и удобные инструменты для анализа данных. Внедрение данной системы способствует оптимизации процессов получения, обработки и распространения информации, что способствует значительному улучшению качества медиамониторинга и скорости предоставления данных.

science-review.ru

science-review.ru